新加坡国立大学广州创新研究院(以下简称“研究院”)博士奖学金由广州市黄埔区提供,目标是依托新加坡国立大学(以下简称“新国大”)丰富优质的教育资源,为广州市黄埔区培养和输送具有全球视野、掌握前沿科技知识、能充分应对21世纪挑战的高素质博士人才。当前AY2024/2025的博士同学正在新国大进行第二年学业,我们将在本栏目持续更新学子们在新国大的进步与收获,记录这些青年学者的成长轨迹。

对于忙碌的科研人员来说,将自己的长篇论文制作成通俗易懂的演示视频,是一项耗时又费力的“苦差事”。从提炼要点、设计幻灯片,到录制配音、后期剪辑,往往需要花费数小时甚至数天的时间。如今,人工智能技术有望将科研人员从这项繁琐的工作中解放出来。

新加坡国立大学Show Lab团队发布了一项研究Paper2Video,可以实现从学术论文到演讲视频的全自动生成。用户只需提供一篇论文、一张人像照片和一段简短音频,AI就能在数十分钟内自动制作出包含专业幻灯片、同步字幕、讲解光标和虚拟讲者的完整演讲视频。该研究的主要负责人正是新国大广州创新研究院博士奖学金获得者、新国大电子与计算机学院博士研究生祝泽宇同学。

Paper2Video快速自动化生成学术展示视频

学子简介

祝泽宇,新加坡国立大学电子与计算机工程专业(ECE)博士二年级研究生,新国大广州创新研究院AY2024/2025博士奖学金得主。他的导师是研究院学术带头人(Principal Investigator)、新加坡国立大学校长青年助理教授Mike Zheng Shou寿政。2024年从西安交通大学钱学森书院人工智能实验班本科毕业后,祝泽宇选择以直博方式进入新加坡国立大学,继续在学术道路上深耕。他的研究兴趣主要集中在视频生成与多智能体系统方向,目前也在探索具身智能相关问题。

祝泽宇研发Paper2Video的想法最初来自一位师兄的启发。他观察到,如今许多研究人员都会通过三到五分钟的视频来介绍自己的研究成果,不少学术会议也将此类视频列为投稿材料的一部分。然而在实践中,人工制作这类视频耗时耗力。因此,祝泽宇开始思考:能否借助大语言模型与视频生成技术,将这一流程自动化,从而帮助研究人员更高效、便捷地分享他们的工作?于是,在坚持不懈的深入研究后,Paper2Video最终诞生。

目前,祝泽宇的团队已全面开源了Paper2Video的代码、数据和模型。

论文链接:https://arxiv.org/abs/2510.05096

项目主页:https://showlab.github.io/Paper2Video/

开源代码:https://github.com/showlab/Paper2Video

开源数据:https://huggingface.co/datasets/ZaynZhu/Paper2Video

学子专访

Q:你为什么会选择“视频生成与多智能体系统”这个研究方向?

A:我对电影和影像叙事有着浓厚兴趣,并关注到高质量视频创作往往受到设备、技术与经验门槛的限制。我的愿景是利用人工智能技术,降低视频创作的复杂度,使更多有叙事意愿的人能够不受客观条件限制地创作和表达。通过AI对视频生成与编辑流程的简化,我希望让视频成为一种更加普适的表达媒介。

Q:你们团队为什么选择全面开源Paper2Video的代码和数据?你最期待看到哪些方向的后续研究?

A:我们之所以选择开源,是希望这一工具不仅停留在论文或demo层面,而是真正被社区使用,帮助更多人更高效地进行视频创作,同时扩大研究工作的影响力。

从个人角度而言,我更期待一种更具趣味性和叙事性的学术视频生成方式。目前的 Paper2Video 仍主要以幻灯片讲解为核心形式,而我认为,若能通过故事化的方式来呈现研究问题、动机与创新点,或许能够显著提升观众在观看过程中的理解深度与兴趣。

Q:请分享下你目前的读博体验,你觉得博士生活和你之前预想的一样吗?你的导师或实验室团队对你产生了怎样的影响?

A:我之前对读博生活的预期就是会比较辛苦,所以整体上和我想象的差不多。对我来说,最大的挑战、也是需要持续培养的能力,是学会接受失败并从失败中总结经验,尤其是在论文投稿过程中,结果往往带有一定的随机性和不确定性。与其把一次拒稿看成否定,我更希望把它当作一次反馈迭代的机会:论证是否扎实、实验是否充分、表达是否清晰,然后用更系统的方法把工作打磨到更强。

在科研学习的过程中,导师和团队成员始终给予我持续而有力的支持,不仅在科研问题的讨论上提供了重要指导,也在生活层面给予了关心与帮助。特别是在科研方面,我从他们身上学习到了系统的研究思路和严谨的学术态度。

Q:请给刚入学的博士学弟学妹们一些建议。

A:我觉得最重要的建议其实是心态层面。一方面,不要过早焦虑,这种情绪会消耗大量能量,却未必真正推动问题的解决;另一方面,也要努力成为一个内心坚强的人,能够在不确定和挫折中持续前行。“focus and resilience”是我认为科研重要的品质,希望学弟学妹们在读博的过程中都能保持专注和韧性。

下面让我们来详细了解一下能够实现学术视频自动化生成的Paper2Video项目。

背景:学术展示视频生成挑战

学术展示视频作为科研交流的重要媒介,制作过程仍高度依赖人工,需要反复进行幻灯片设计、逐页录制和后期剪辑,往往需要数小时才能产出几分钟的视频,效率低下且成本高昂,这凸显了推动学术展示视频自动化生成的必要性。然而,与自然视频生成不同(如Sora2、Veo3等扩散模型),学术展示视频面临以下独特挑战:

长文档与高密度输入(Multi-modal Long-context Input): 来源于完整学术论文,包含大段专业文本、复杂公式、多幅图表,远超自然视频的输入复杂度

多模态通道的协同生成(Coordination of Multiple Aligned Channels): 需要同时生成并对齐幻灯片、字幕、语音、光标轨迹与讲者视频,保证多模态之间的语义一致性与时序同步

缺乏专门的评价标准(Lacks Well-defined Evaluation Metrics): 现有视频生成指标主要关注画面质量或风格一致性,难以衡量学术展示视频在知识传递、受众理解与学术可用性上的效果

因此,现有自然视频生成模型和简单的幻灯片+语音拼接方法难以胜任,亟需一个系统化的基准和方法来推动自动化、可用的学术视频生成。为了解决以上挑战,本研究提出了Paper2Video基准对学术展示视频进行评价,并提出一个多智能图框架PaperTalker,为实现自动化和可用的学术视频生成迈出切实可行的一步:

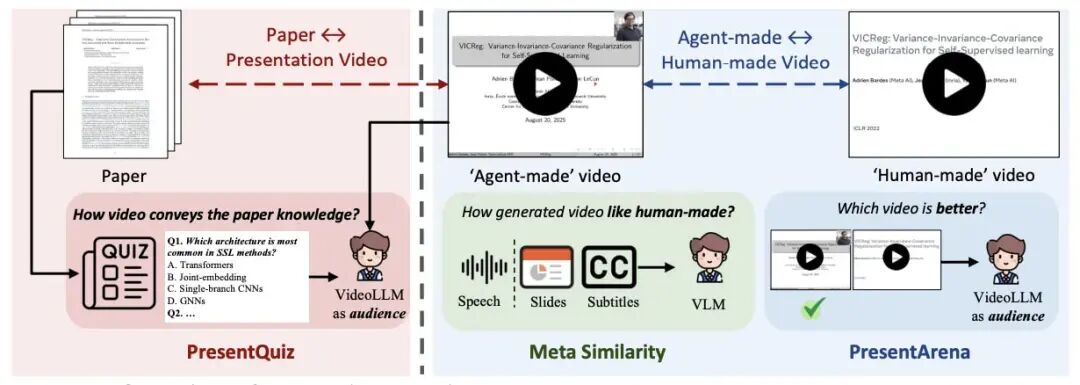

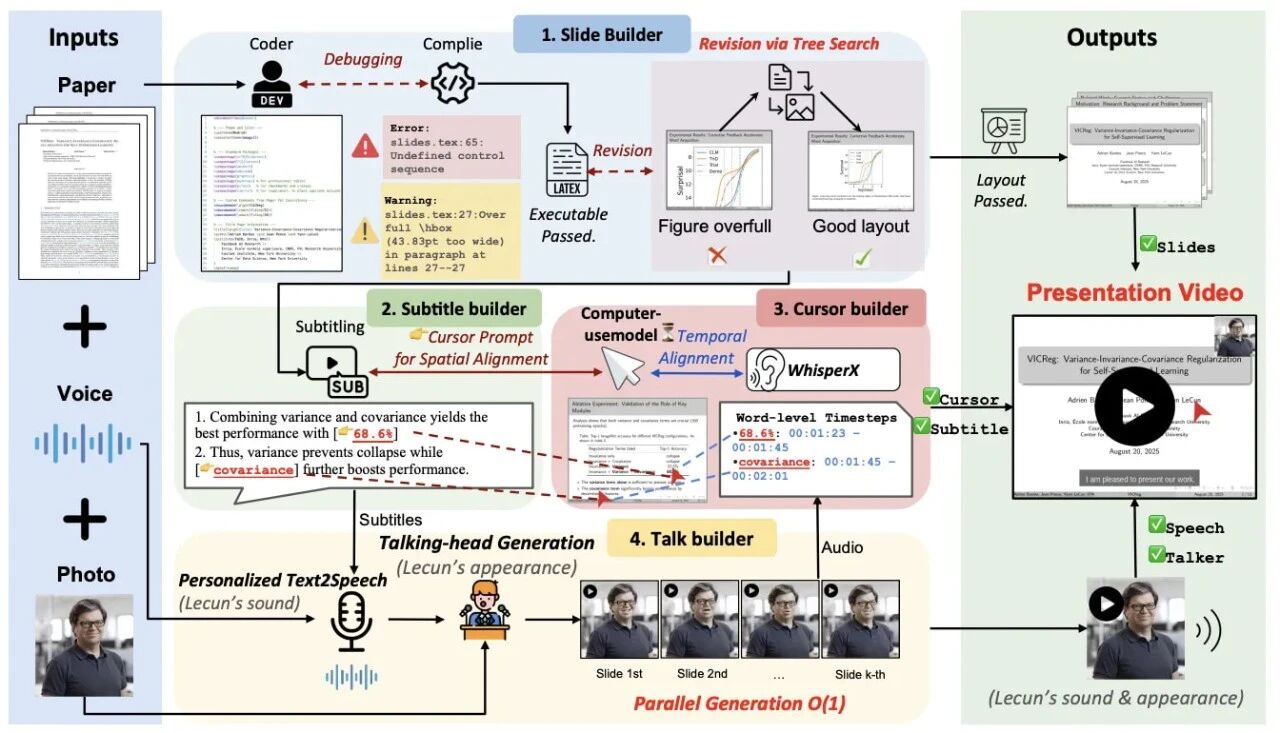

图1: Paper2Video概览

Paper2Video评价基准

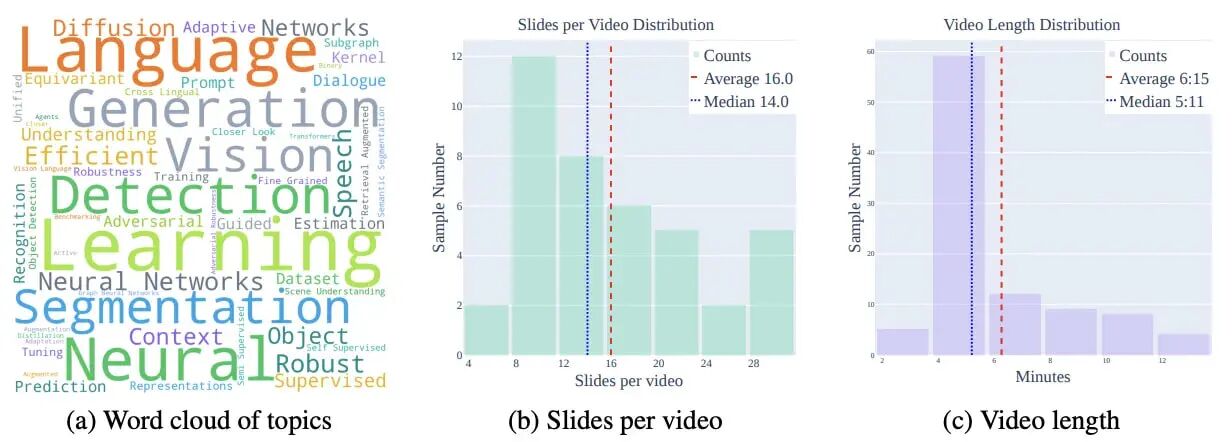

为了评价学术展示视频的质量,本研究收集了101篇论文和对应的作者录制的学术展示视频作为测试基准,并从学术展示视频的用途出发,提出了四个评价指标: Meta Similarity, PresentArena, PresentQuiz和IP Memory。

图 2: Paper2Video 基准统计概览

Paper2Video基准收集了来自近三年顶会的 101 篇论文及其作者录制的展示视频,涵盖机器学习、计算机视觉与自然语言处理领域。每个样例包含论文LaTeX工程、幻灯片、展示视频、讲者肖像与语音样本,其中部分还提供原始PDF幻灯片。数据统计显示,论文平均13.3K字、44.7幅图表,展示视频平均16页幻灯片、时长6分钟。

作为首个系统化的学术展示视频基准,它为多模态长文档输入与多通道输出(幻灯片、字幕、语音、光标、讲者)的生成与评估提供了可靠依据,为推动自动化学术展示视频生成奠定了基础。

Paper2Video 评价指标

本研究从学术展示视频的用途出发,认为其质量应从三个核心视角进行衡量:

类人一致性:生成的视频应与作者精心设计的人类版本保持相似,反映人类偏好。

信息传递性:生成的视频应尽可能涵盖论文中的关键信息,并被受众正确理解。

学术影响力:生成的视频应能突出作者的学术身份,并增强观众对该工作的记忆。

基于上述视角,我们设计了四个互补的评价指标:

Meta Similarity — 类人相似度(内容级): 比较生成的幻灯片、字幕和语音与人类版本的一致性,衡量生成结果在细节和风格上的接近程度。

PresentArena — 类人一致性(观感级): 使用 VideoLLM 作为代理观众进行成对对比,从清晰度、流畅性与吸引力等维度判断生成视频是否符合人类偏好。

PresentQuiz — 信息传递性: 通过基于论文构造选择题,使用VideoLLM 作为代理观众进行问答,测试生成视频能否覆盖并有效传递论文中的关键信息。

IP Memory — 学术影响力: 模拟会议场景,使用VideoLLM 作为代理观众,评估观众是否能够在观看后将视频与作者身份和研究工作正确关联,反映学术可见性与记忆度。

四个指标共同构建了一个覆盖类人偏好、信息传递与学术记忆的系统化评价框架,为学术展示视频生成的客观测评提供了可靠依据。

PaperTalker多智体架构

图4: PaperTalker流程简介

为解决学术展示视频制作繁琐且难以自动化的问题,本研究提出了PaperTalker —— 首个支持学术展示视频生成的多智能体框架,用于处理这一具有长时依赖的多模态智能体任务(Long-horizon Multi-modal Agentic Task)。该框架以研究论文、讲者图像与语音样本为输入,自动生成包含幻灯片、字幕、语音、光标轨迹和讲者视频 (slide creation, subtitling, speech, cursor highlight, talking head) 的完整展示视频。

PaperTalker 由四个关键构建模块组成:

1. Slide Builder:基于论文内容生成LaTeX Beamer幻灯片,并引入Tree Search Visual Choice模块克服大语言模型在细粒度数值调整上的局限,从而优化版面布局,确保幻灯片布局合理设计。

2. Subtitle Builder:利用视觉语言模型从幻灯片提取关键信息,生成逐句字幕及对应的视觉焦点提示词。

3. Cursor Builder:结合UI-Grounding和WhisperX模型,实现光标在时间和空间上的精准对齐,在演讲过程中,引导观众关注关键信息。

4. Talker Builder:根据讲者肖像与语音样本,合成身份一致、唇形同步的个性化讲者视频,并支持逐页并行生成以提升效率。

由此,PaperTalker通过模块化的多智能体协作,实现了可控、个性化、学术风格化的展示视频生成。

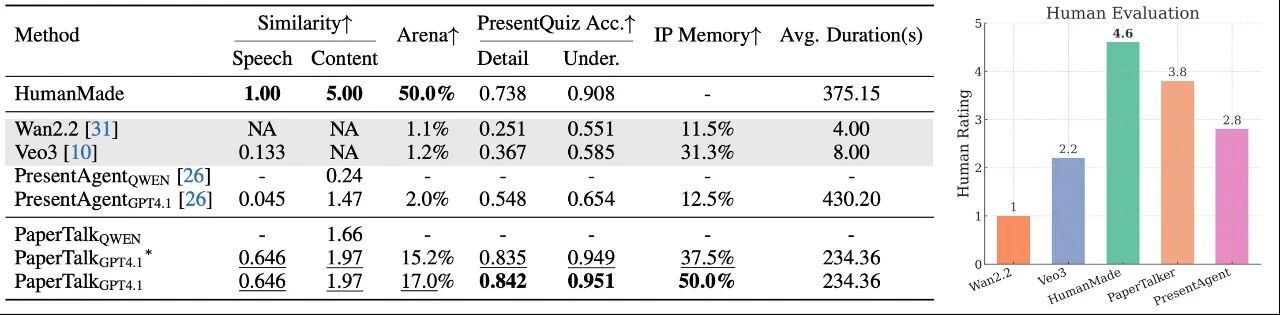

基于Paper2Video基准的实验与评估

在实验中,我们对比了三类方法:(i) 端到端方法(如 Wan2.2、Veo3),直接从文本或提示生成视频;(ii) 多智能体框架(如PresentAgent、PPTAgent),将论文内容转化为幻灯片并结合文本转语音生成展示视频;(iii) 本文提出的PaperTalker,通过幻灯片生成与布局优化、字幕与光标对齐以及个性化讲者合成来生成的学术展示视频。

图5: 学术演示视频性能比较

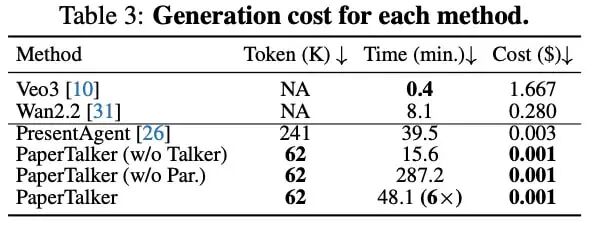

实验结果表明,PaperTalker在Meta Similarity、PresentArena、PresentQuiz和IP Memory 四个维度均取得最佳表现:其生成的幻灯片、字幕与语音更接近人类作品,整体观感更受偏好,知识传递更完整,且在学术身份记忆方面更具优势;同时,人类主观评价也显示PaperTalker的视频质量接近人工录制水平。此外,PaperTalker在生成成本上最低。

图6:模型效率比较

结 语

本研究提出的Paper2Video基准与PaperTalker框架,为学术展示视频生成提供了系统化任务与评测体系。实验验证了其在信息传递、观感质量与学术记忆方面的优势,生成效果接近人工水平。我们期待这项工作能推动AI4Research的发展,促进科研交流的自动化与规模化。

感谢祝泽宇同学的分享。Paper2Video的研究,既是技术对效率的回应,也是祝泽宇对“让技术服务于表达”这一理念的坚定实践。他说科研需要“专注与韧性”,而他正以这样的姿态,在这条连接人工智能与人文叙事的道路上,走向下一个问题,写下新的可能。前行不止,探索不息。